Everything-as-a-Service bei der SmartIT

HPE kündigt an der Discover more in München die zentrale Management Plattform Greenlake Central an. Eine zentrale Management Plattform, welche es den Kunden erlaubt die gesamte hybride IT-Infrastruktur zu managen - alles as-a-Service.

Ein grosser Teil der Vertreter der Schweizer HPE Partner und Kunden haben Anfang Dezember die Reise an die diesjährige HPE Discover more aufgenommen. Neu ist die Discover more speziell auf die DACH-Region (und Russland) zugeschnitten. Zwei spannende Tage, die inspirieren und die Werkzeuge in die Hand geben, um unsere Kunden voranzubringen.

HPE Greenlake Central

In der General Session hat Antonio Neri, CEO von HPE, HPE Greenlake Central vorgestellt. Eine Management Plattform, welche es den Kunden ermöglicht ihre hybride IT-Infrastruktur zu verwalten. Ein weiterer Schritt, welcher HPE vom klassischen Hardware-Hersteller zum Service-Dienstleister transformiert. Nach dem Motto: «Everything as a Service». Die Strategie von HPE ist bis 2022 das gesamte Portfolio «as a Service» anzubieten.

Heute basiert der Greenlake-Service auf einer Reihe von Optionen für virtuelle Maschinen, die von HPE, Nutanix und VMware angeboten werden. Weltweit sind es heute zwischen 700 - 800 Kunden, welche den Service nutzen. Mit der Ankündigung von Greenlake Central und der Container Plattform erhofft sich HPE hier ein grosses Wachstum.

Der General Release von Greenlake Central ist für das erste Halbjahr 2020 geplant.

Cloud is not a Destination, it‘an Experience

Bis vor drei bis vier Jahren wurde nur eine Richtung angepriesen: Cloud, Cloud und nochmals die Cloud. Heute ist alles hybrid und die Daten werden «at the Edge» produziert. «Jedes Unternehmen stellt auf die Cloud um, hat dabei aber mehr Schwierigkeiten als erwartet. Und das grösste Problem ist ein bestimmter Faktor – der Mensch. Um erfolgreich zu sein, müssen Sie von der bisherigen Denkweise auf eine neue Art der Geschäftstätigkeit umstellen. Ihre Teams müssen mit der Organisation, der Bereitstellung und der Nutzung der Cloud vertraut sein.» Robert Christiansen, Chief Cloud Strategist, HPE. Was sich geändert hat, ist die Bereitstellung und die Anforderung an die Agilität der Infrastruktur. Heute wollen Kunden bspw. eine App in der Cloud testen und im Anschluss produktiv in der OnPrem-Infrastruktur bereitstellen - oder umgekehrt. Je nach Ressourcen oder Anwendungszweck. HPE bietet Unternehmen eine grosse Auswahl an Hybrid Cloud-Lösungen und ermöglicht ein nahtloses Erlebnis in allen Clouds.

Ein Beispiel hier sind die HPE Cloud Volumes. HPE Cloud Volumes bietet die Möglichkeit, Blockspeicher für die Cloud bereitzustellen, wobei die Compute-Leistung von einem der drei wichtigsten Cloud-Anbieter bereitgestellt wird. Google, AWS oder Azure. Kurz gesagt, Sie erstellen ein Cloud Volumes-Konto über ein Webportal, erstellen die VM beim Cloud-Anbieter des Vetrauens und wählen dann ein HPE Cloud Volumes als Datenträgerziel aus. HPE stellt den Speicher bereit, indem die Rechenzentren der Cloud Hyperscalers entweder gemeinsam oder ganz in der Nähe angeordnet werden, um die Latenz zu minimieren. Die HPE-Rechenzentren enthalten HPE Nimble-Speicherarrays, die den zugrunde liegenden Speicher für Cloud Volumes bereitstellen. HPE verwendet das InfoSight-System, um sicherzustellen, dass Verfügbarkeit, Kapazität und Skalierbarkeit durch das Predictive Analytics-System erreicht werden.

Besitzen Sie heute schon ein HPE Nimble Storage?

Mit HPE Cloud Volumes können Sie die HPE Cloud Volume auch als Replikationsziel für alle HPE Nimble Storage-Systeme verwenden. Das kann einerseits als DR-Szenario dienen, für eine aktive Test-Umgebungung oder auch für die temporäre Bereitststellung von zusätzlichem Speicher bei Migrationen. Mit der Integration der Cloud Volumes in die lokale HPE Nimble Konsole können mittels weniger Klicks Daten in die Cloud oder zurück verschoben werden.

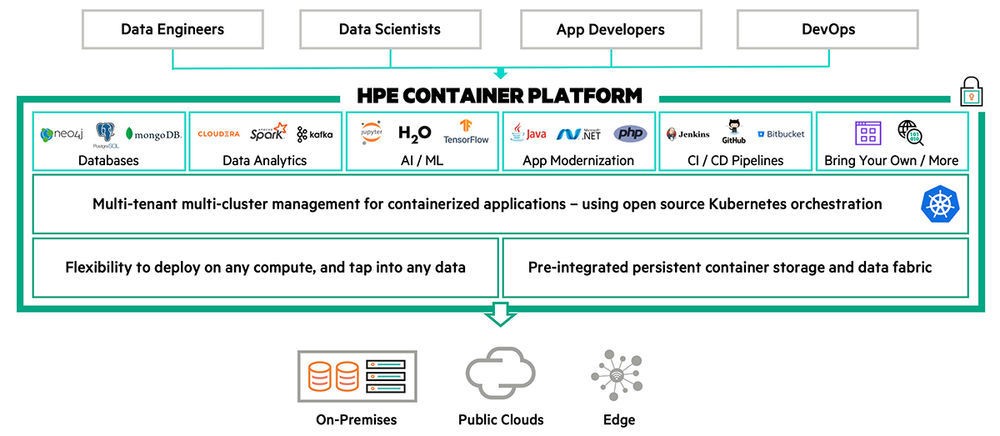

HPE Container Plattform

Grundlage der HPE-Container Plattform bilden die Technologien von zwei Akquisitionen (Bluedata und MapR) in Verbindung mit dem Open-Source-System Kubernetes. Die Bluedata-Software dient als Steuerungsebene für das Container-Management und das MapR-Dateisystem für persistente Daten mit Containern und Kubernetes für die Container-Orchestrierung.

Kumar Sreekanti, CTO Hybrid IT bei HPE, erläutert den Hintergrund: «Die Anwendungs-Entwicklung wird zunehmend in Containern durchgeführt. Und hier ist Kubernetes faktisch der Standard für die Container-Orchestrierung.»

Der HPE Container Platform Service soll den Kunden im Zeitalter der Anwendungsagilität helfen sich schnell anpassen zu können. Die Ziele des Service sind einfach: schnellere Bereitstellung von Anwendungsservices und Senkung der Kosten und Herausforderungen bei der Übernahme der neuesten Container-Strategien. Mit diesem Service sollen Kunden ihre Containerplattformen in der Cloud, aber auch lokal auf skalierbare und zuverlässige Weise ausführen können.

Edge, Edge, Edge

Ein grosses Thema an der diesjährigen Discover war Edge Computing. Beim Edge Computing werden die Daten vom Gerät selbst oder von einem lokalen Computer oder Server verarbeitet und nicht oder erst nach Verarbeitung an ein Rechenzentrum übertragen. Es schafft die Grundlage für Mobile Computing und IoT-Technologien (Internet der Dinge).

Laut HPE werden bis 2023 die meisten Daten in einem ersten Schritt «at the Edge» erstellt und verarbeitet, nicht in der Cloud oder in einem Rechenzentrum: Moderne Arbeitsplätze, IoT-Geräte oder ein vollständig vernetztes Stadion (das umgebaute Hockeystadion von HC Fribourg-Gottéron oder das Prunkstadion vom Londoner Fussballclub Tottenham Hotspurs).

In diesem Bereich setzt HPE u.a. auf die Produktelinien Edgeline und Aruba. Ein Anwendungsbeispiel, welches insebesondere manchem Motorsport-Fan gefallen hat, ist jenes vom Formel1-Rennstall von Mercedes. Das Team, welches vor wenigen Tagen zum 6. Mal in Folge Weltmeister wurde. Matt Harris von Mercedes-AMG Petronas Motorsport erläuterte, dass die Herausforderung des Teams war, die benötigte Zeit für Simulationen vor einem Rennen zu verkürzen und in Echtzeit auf veränderte Parameter (Verhalten der Konkurrenz, technische Sensoren an den Fahrzeugen etc.) während einem Rennen zu reagieren und auf diese Weise schnell Strategien anpassen zu können. Faktoren, welche viel Leistung on-premise benötigen. Für weitere, detailliertere Analysen kommt anschliessend der Hybrid-Cloud Ansatz zum Zug, bei dem die Daten ins Headquarter in England übermittelt werden und dort «in Ruhe» von einer Schar von Ingenieuren verarbeitet werden. Dank der Implementation von HPE Apollo und der HPE Edgeline-Technologie, werden die Simulationen vor dem eigentlichen Rennen verbessert und Echtzeit-Computing an der Rennstrecke ermöglicht.

Dr. Eng Lim Goh, Senior VP und CTO von HPE, zeigte diverse spannende Einsatzgebiete von Edge-Computing, Machine Learning und Swarm Intelligence. Warum Edge-Computing auf einer zukünftigen Mars-Mission unumgänglich ist, wie Maschinen selber lernen und was Blockchain mit einem Notizbuch zu tun hat, können in einer seiner absolut sehenswerten Vorträge auf Video nachgeschaut werden. Leider ist Dr. Eng Lim Gohs Session von der Discover more (noch) nicht online verfügbar. Hier ein Vortrag von Ende November.

HPE kann heute Lösungen für die Bereitstellung sämtlicher Infrastruktur-Anforderungen liefern. Mit wichtigen Partnerschaften, Neuentwicklungen und intelligenten Zukäufen kommt HPE ihrem Ziel immer näher: Alles als Service anbieten.

Hier finden Sie die Highlights sowie die Slidedecks der HPE Discover More.

Haben Sie Interesse an den neusten HPE-Technologien oder insbesondere an HPE Cloud Volumes? So zögern Sie nicht und kontaktieren Sie uns noch heute.