Was ist eigentlich «Edge-Computing»? Fallbeispiel from Outer Space!

Sie haben vielleicht auf den Webseiten von Herstellern wie HPE oder Microsoft etwas dazu gelesen oder haben an einer Konferenz davon gehört: «Computing at the Edge». Die Reaktionen sind üblicherweise: «OK. Wow. Ehm was?» Nun, diese Frage habe ich mir und anderen auch gestellt und mir natürlich auch Gedanken gemacht, was das für unsere Kunden und SmartIT bedeutet. Im folgenden Blog-Artikel versuche ich ein wenig Licht ins Dunkle zu bringen und anhand eines (zugegebenermassen etwas abwägigen aber dennoch) faszinierenden Beispiels «Edge Computing» zu erklären.

Alles in die Cloud – oder doch nicht?

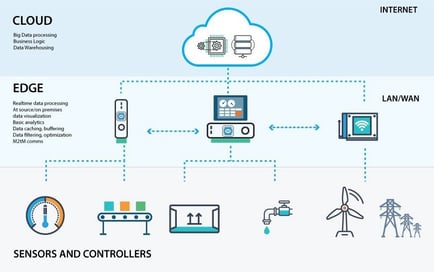

Der Trend weg von dezentralisierten IT-Lösungen und die zunehmenden Verschiebung in die Cloud führt unweigerlich zu neuen Herausforderungen. Eine davon ist die Tatsache, dass die Rechenleistung nicht mehr zwingend an der Datenquelle stattfindet. Das bedeutet, dass generierte Daten zuerst in die Cloud verschoben werden, dort mit schier unendlichen Ressourcen verarbeitet werden können, das Resultat aber oft wieder zurück an die Quelle muss. Wie schnell diese Daten wieder zurück an der Quelle sein müssen, hängt natürlich vom Usecase ab. Stellen Sie sich mal Folgendes vor: ein autonom fahrendes Auto erfasst unterwegs ganz viele Parameter – Geschwindigkeit, Einschlagwinkel der Steuerung, Batterlieladezustand und vor allem Umgebungsparameter wie Verkehr, Fussgänger, Strassenschilder und Weiteres. Die Verarbeitung dieser Daten in der Cloud wäre durchaus effektiv. Aber was passiert wenn keine Verbindung zur Cloud besteht oder die Verbindung hohe Latenzen hat und das Fahrzeug erst 1 Sekunde später auf einen Fussgänger auf der Strasse reagieren kann? Genau, nicht denkbar. Aus diesem Grund muss die Datenverarbeitung von diesen sehr zeit- und verbindungskritischen Daten zwingend direkt im Fahrzeug erfolgen – at the Edge. Trotzdem werden Daten im Hintergrund in die Cloud veschoben, dort verarbeitet und wieder zurück ans Fahrzeug gesendet. Sei es zur statistischen Auswertung um das Fahrverhalten zu optimieren, optimierte Routenplanung unter Einbezung der aktuellen Verkehrslage oder auch einfach zur Systemüberwachung.

Es gibt immer wieder Beispiele, in denen zwar Cloud-Dienste durchaus einen Mehrwert bringen, die Verarbeitung von Echtzeitdaten aber zu zeitkritisch ist, um sie in die Cloud auszulagern. Hier kommt nun «Edge Computing» zum Zug. Dazu kommen unter anderem vorkonfigurierte Hardwarekomponenten wie beispielsweise von HPE zum Einsatz, welche über CPU, RAM und Speicher verfügen, oft sehr formkompakt sind und für die direkte Anbindung an Cloud Services vorbereitet sind. Es wird dabei viel Wert auf durchgehende Programmiersprachen und vereinheitlichte Interfaces gesetzt. Die Entwickler haben den Anspruch, eine Software aus der Cloud einfach und unkompliziert ans Edge zu deployen und den Datentransfer über möglichst standardisierte Interfaces zu realisieren.

Edge Computing in Outer Space

Unser Hardware Partner Hewlett Packard Enteprise (HPE) setzt sich bereits seit Jahrzenten stark für Forschung und Entwicklung ein. Unter anderem auch im Bereich der Weltraumforschung.

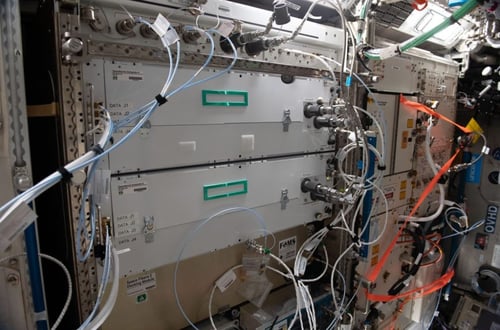

So hat HPE vor ein paar Jahren erfolgreich einen mehr oder weniger handelsüblichen Server in der Internationalen Raumstation (ISS) in Betrieb genommen , um zu beweisen, dass die Qualität der verbauten Teile durchaus erschwerten Bedingungen wie einem Raketenstart, Schwerelosigkeit und Dauerbetrieb standhalten können. Es wurde dabei auch aufgezeigt, dass sowohl der Ein- als auch Ausbau und die Wartung dieser Geräte von einem Nicht-IT Fachmann/Frau - aka Astronauten – erledigt werden können.

HPE hat nun zusammen mit Microsoft die zweite Generation, den Spaceborne Computer-2 (SBC-2), erfolgreich auf der ISS in Betrieb genommen. Die beiden Hersteller bringen dabei Artificial Intelligence (AI) und Big-Data-Analyse in den Weltraum. Microsoft beschreibt das Gerät in einem Blogartikel als «Supercomputer von der Grösse eines kleinen Mikrowellenherds, der vom Weltraum aus mit der Cloud verbunden ist». Es besteht aus dem HPE Edgeline EL4000 Converged Edge System und dem HPE ProLiant DL360 Gen10 Server.

Der SBC-2 kann grosse Datenmengen verarbeiten und AI-Algorithmen direkt an der Quelle (at the edge) ausführen. Für Weltraumforschungsmissionen ist dies essenziell, da die verfügbare Bandbreite für Daten, welche an Teams auf der Erde übertragen werden müssen, stark limitiert sind.

Astronauten-DNA sequenzieren und selektive Filterung von Genomdaten

Der Titel tönt kompliziert, ist es vermutlich auch. Den SBC-2 nutzen die Forscher unter anderem für ein Experiment zur Überwachung der Gesundheit der Austronauten. Ziel ist es, ihre DNA regelmässig zu sequenzieren, um mögliche schädliche genetische Mutationen aufzuspüren. Dieses Risiko besteht seit die Menscheit den Weltraum erobert hat, denn Astronauten sind aufgrund der fehlenden schützenden Erdatmosphäre einer erhöhten kosmischen Strahlung ausgesetzt. Die Ergebnisse der Sequenzierung müssen mit einer grossen, ständig aktualisierten klinischen Datenbank auf der Erde abgeglichen werden. Und da fangen die Probleme spätestens an: Die dafür benötigte Rohdatenmenge von etwa 200GB ist viel zu gross für den Downlink der NASA. Diese stellt den Forschern lediglich eine Download-Geschwindigkeit von 250Kb/s für maximal 2 Stunden pro Woche zur Verfügung! Wir fühlen uns in die 90er Jahre und den kreischenden Modems zurückversetzt.

Angesichts dieser Limitierung lassen die Forscher den SBC-2 zuerst die extrahierten genetischen Sequenzen mit Referenz-DNA-Segmenten vergleichen. Danach werden nur noch die Unterschiede bzw. die Mutationen in die Cloud verschoben. Diese Genomstücke mit vermuteten Anomalien werden dann mit der Datenbank des National Instritute for Health verglichen, um ihre Auswirkungen auf die Gesundheit der Astronauten zu ermitteln.

Erfolgreiches Experiment für Microsoft, HPE und NASA – aber für SmartIT-Kunden?

Gabe Monroy, Head of Developer Experience bei Microsoft Azure, sagt das Experiment wäre ein absoluter Erfolg gewesen und habe den Mehrwert eines Edge-to-Cloud-Workflows für Weltraumstationen wie die ISS bewiesen. Ohne diese Vorverarbeitungen des SBC-2 hätten etwa 150 Mal mehr Daten an die Erde übermittelt werden müssen, was alleine mehr als zwei Jahre gedauert hätte. Im Experiment wurden die Daten in etwas mehr als zwei Stunden übermittelt.

Was bedeutet der Erfolg dieses Forschungsexperiments aber für unsere Kunden und SmartIT? Nun auch wenn unsere Kunden im Moment (noch) nicht auf dem Mond zu Hause sind, treffen wir doch immer wieder auf Situationen, in denen zwar ein Workload in die Cloud verschoben werden möchte, aufgrund von limitierten Anbindungen an die Cloud und den daraus resultierenden Latenzen ein effizentes Verarbeiten der Daten aber nicht möglich ist. Konkrete Beispiele gibt es in der Industrie - Maschinensteuerungen, welche mit IoT Sensoren überwacht und gesteuert werden müssen oder Alarmierungssysteme, welche sehr zeitnah Daten von Sensoren auswerten und darauf reagieren müssen. Wir betreiben bereits heute bei Kunden eine Art «Edge-Computing» auch wenn wir dem vielleicht nicht so sagen.

Weiterführende Links:

Empfehlenswertes Video welches von HPE und Microsoft produziert wurde: https://www.youtube.com/watch?app=desktop&v=wZfIUkcgVxI&t

Ausführliche Erklärung von HPE:

https://www.hpe.com/us/en/newsroom/Accelerating-space-exploration-with-the-Spaceborne-Computer.html

https://www.hpe.com/us/en/newsroom/Accelerating-space-exploration-with-the-Spaceborne-Computer.html